使用ChatGPT自动化抓取网页

Web 抓取是Python学习中使用脚本从网站自动提取数据的过程。ChatGPT 能够为您生成网络抓取脚本代码。

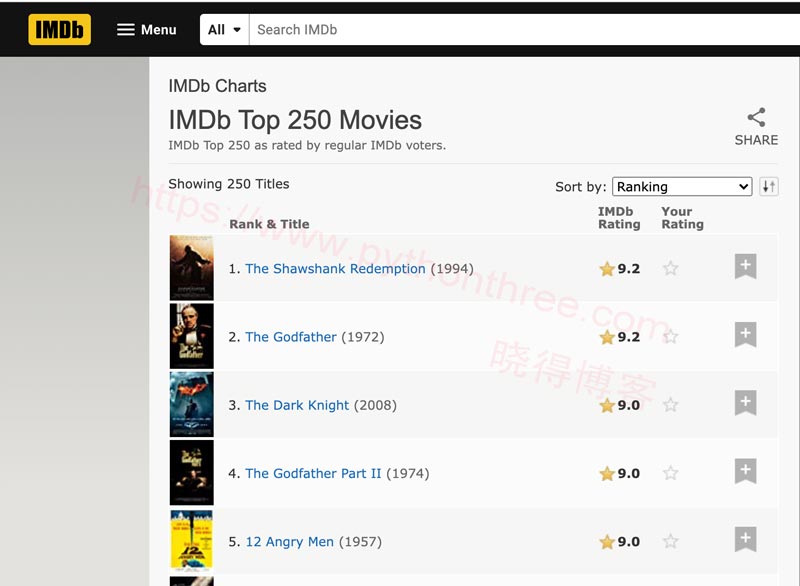

IMDb 是一个提供有关电影、电视节目和其他娱乐形式的信息的网站,包括评分最高的电影排行榜,该网站 显示了IMDb 评分最高的 250 部电影列表,包括片名、演员、导演和 IMDb 评分。

ChatGPT使用BeautifulSoup抓取网页

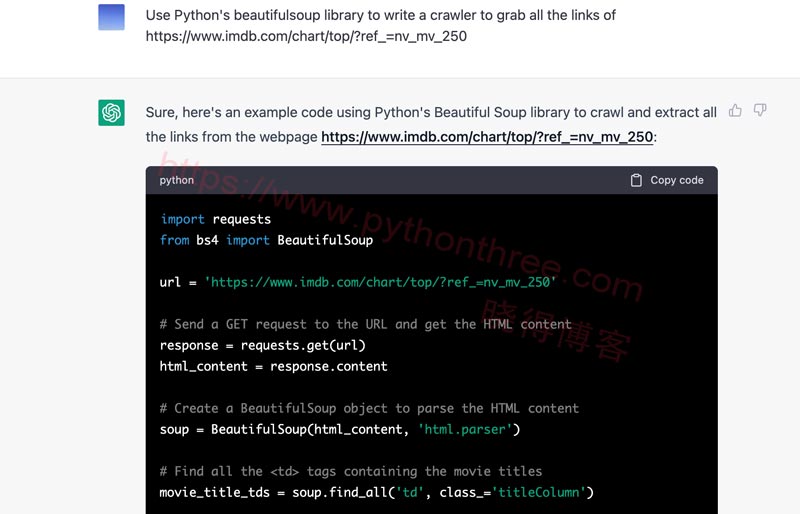

假设我们想使用网络抓取通过 Python 及其网络抓取库 BeautifulSoup 从该网站提取电影信息。ChapGPT 能够帮助我们编写所需的代码,ChatGPT 以具体的实现步骤和相应的 Python 源代码作为响应,更贴心的是ChatGPT还给出了代码解析。

import requests

from bs4 import BeautifulSoup

url = 'https://www.imdb.com/chart/top/?ref_=nv_mv_250'

# Send a GET request to the URL and get the HTML content

response = requests.get(url)

html_content = response.content

# Create a BeautifulSoup object to parse the HTML content

soup = BeautifulSoup(html_content, 'html.parser')

# Find all the <td> tags containing the movie titles

movie_title_tds = soup.find_all('td', class_='titleColumn')

# Extract the href attribute from each link tag and store it in a list

movie_links = []

for movie_title_td in movie_title_tds:

movie_link = movie_title_td.a.get('href')

movie_links.append('https://www.imdb.com' + movie_link)

# Print all the links

for link in movie_links:

print(link)

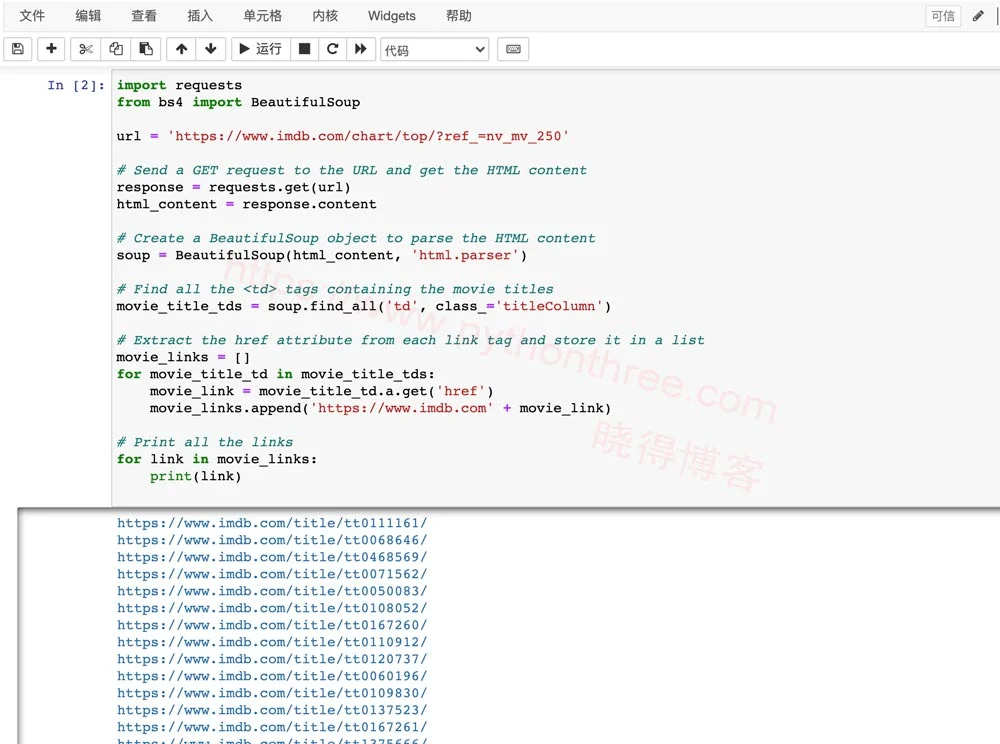

运行结果如下面的屏幕截图所示:

ChatGPT使用Scrapy抓取网页

Scrapy是一个基于Python的网络爬虫框架,可以让你轻松搭建各种网站的网络爬虫。Scrapy 提供了一个高级 API 和一套工具来帮助您从网站中提取数据,它还处理许多常见的爬行任务,例如 URL 管理、请求调度和蜘蛛中间件

以下是ChapGPT给出的可以编辑的imdb_spider.py文件来定义蜘蛛的爬行行为,例如从网页中提取哪些元素以及如何跟踪到其他页面的链接。

import scrapy

class ImdbSpider(scrapy.Spider):

name = "imdb"

start_urls = [

'https://www.imdb.com/chart/top/',

]

def parse(self, response):

for movie in response.css('.lister-list tr'):

link = movie.css('td.titleColumn a::attr(href)').get()

yield {

'link': f'https://www.imdb.com{link}',

}

推荐:使用BeautifulSoup从HTML中抓取网址链接

总结

以上是晓得博客为你介绍的使用ChatGPT自动化抓取网页的全部内容,ChatGPT 在生成用于网络抓取的脚本时非常有帮助。只需将简单的要求输入到 ChatGPT 中,就会收到了一个 Python 脚本,代码无需任何调整即可执行,使网络抓取变得更加容易,希望对你的ChatGPT使用有所帮助。